Erstellen Sie in Ihrem Browser ausführbare UML-Aktivitätsdiagramme. Sie können eingehende E-Mails verarbeiten, auf Kunden-Auswahl oder -Antworten warten und lokale oder Remote-KI-Chatbot-Endpunkte für die Verarbeitung natürlicher Sprache verwenden.

Erstellen Sie in Ihrem Browser ausführbare UML-Aktivitätsdiagramme. Sie können eingehende E-Mails verarbeiten, auf Kunden-Auswahl oder -Antworten warten und lokale oder Remote-KI-Chatbot-Endpunkte für die Verarbeitung natürlicher Sprache verwenden.

Modellieren Sie Entscheidungen, empfangen, senden und verschieben Sie E-Mails, führen Sie Stimmungsanalysen für Texte durch und binden Sie sogar benutzerdefinierte Python-Skripte ein. Cocosplate ist eine moderne, benutzerfreundliche Plattform, die Ihre Arbeitsabläufe visualisiert und verständlicher macht. Sie bietet eine einfache Intranet-Bereitstellung und ein erschwingliches Lizenzmodell, das auf mittelständische Unternehmen zugeschnitten ist.

Modellieren Sie Entscheidungen, empfangen, senden und verschieben Sie E-Mails, führen Sie Stimmungsanalysen für Texte durch und binden Sie sogar benutzerdefinierte Python-Skripte ein. Cocosplate ist eine moderne, benutzerfreundliche Plattform, die Ihre Arbeitsabläufe visualisiert und verständlicher macht. Sie bietet eine einfache Intranet-Bereitstellung und ein erschwingliches Lizenzmodell, das auf mittelständische Unternehmen zugeschnitten ist.

Installation von Cocosplate mit Docker in 3 Schritten

Mit Docker können Sie eine Installation ganz einfach einrichten und verwalten. Docker kann von https://www.docker.com/products/docker-desktop für eine Installation auf Windows- oder Mac OS X-Systemen heruntergeladen werden. Wenn Sie mit Linux vertraut sind, können Sie die Docker-Installation Ihrer bevorzugten Distribution verwenden.

- Laden Sie sich die Datei cocosplate.zip herunter und entpacken diese, sie enthält eine docker-compose.yml zum Starten.

Die sha256-Prüfsumme ist 4d2f2beac05b4aa59c4578d4ffdce9cbcde608740f06759ba16dbaa18817aed4 - Starten Sie das System, indem Sie den folgenden Befehl im Cocosplate-Verzeichnis der Zip-Datei eingeben:

docker compose up -dDamit werden die aktuellsten Systemabbilder heruntergeladen und der Server gestartet.

- Öffnen Sie einen Browser mit der Adresse http://localhost:8081, ein Login-Dialog wird dargestellt.

Melden Sie sich mit dem Benutzernamen admin und dem initiale Passwort Login-AI-Workflow-257 an und testen das System bevor eine Lizensierung erforderllich wird.

Features

Dieser Abschnitt zeigt einige der verfügbaren Highlights von Cocosplate AI. Da die Aktivitätsdiagramme angepasst werden können, sind Ihre Möglichkeiten zur Erstellung von Workflows nahezu endlos.

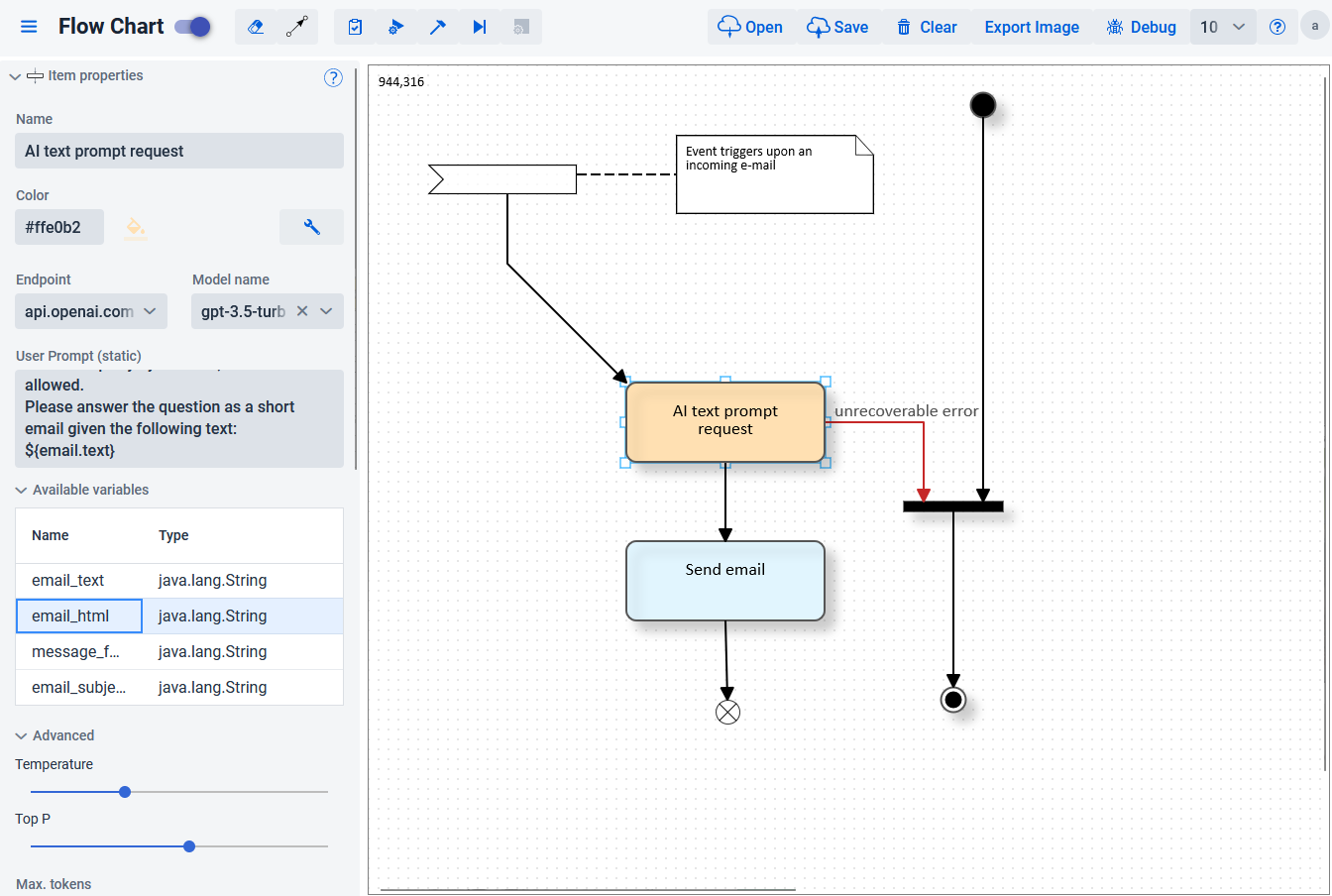

Verwenden Sie große Sprachmodelle in der automatisierten KI-Verarbeitung und Stimmungserkennung für den Kundenservice

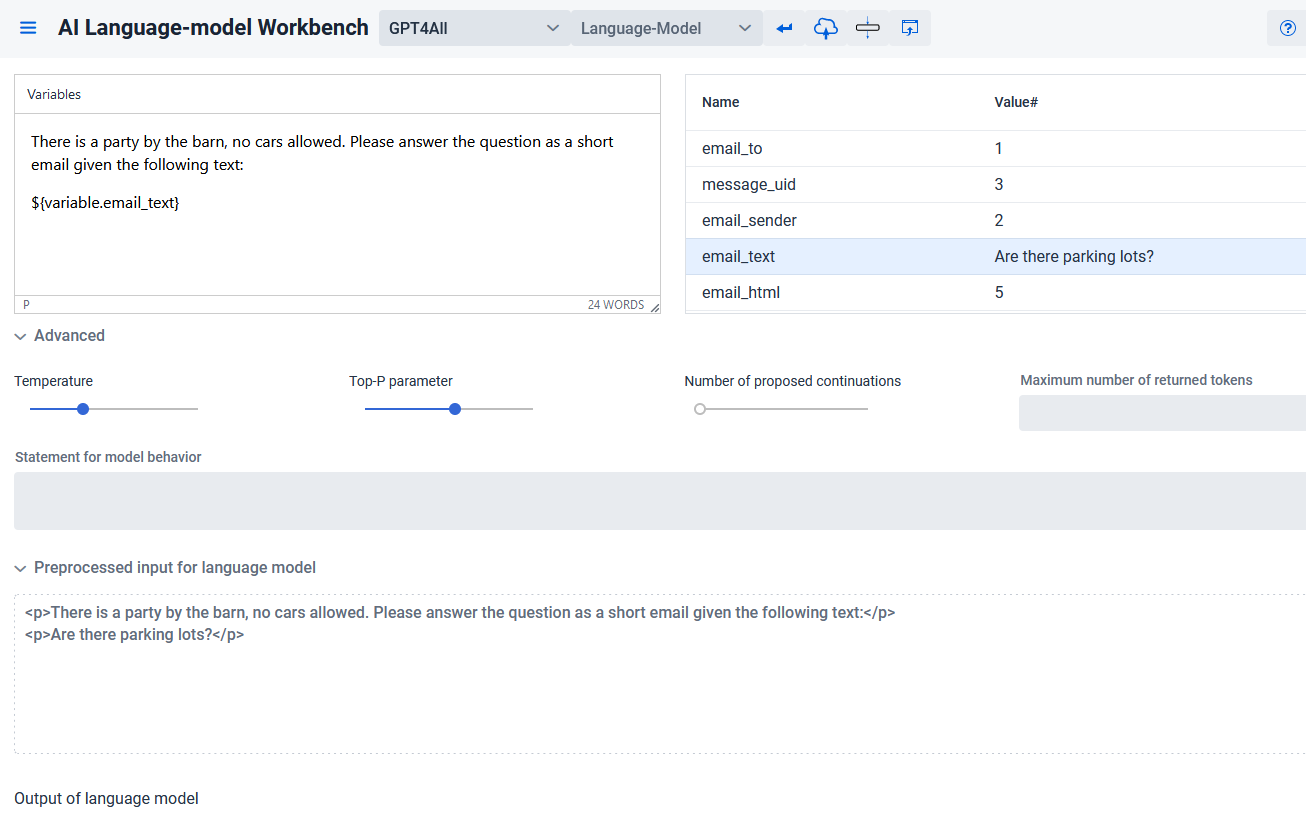

Die AI Workbench ermöglicht es, LLM-Prompts sofort auszuwerten und daraus einen Verarbeitungsknoten in Ihrem Aktivitätsdiagramm zu erstellen.

Das System unterstützt derzeit die OpenAI-API (Abonnement erforderlich) und kann zusätzlich mit einem lokalen oder über das Intranet zugänglichen Sprachmodell wie llama2 mit GPT4all betrieben werden, über das Sie die volle Kontrolle haben. Auf diese Weise können Sie ein Setup erstellen, das der europäischen DSGVO entspricht.

Das System unterstützt derzeit die OpenAI-API (Abonnement erforderlich) und kann zusätzlich mit einem lokalen oder über das Intranet zugänglichen Sprachmodell wie llama2 mit GPT4all betrieben werden, über das Sie die volle Kontrolle haben. Auf diese Weise können Sie ein Setup erstellen, das der europäischen DSGVO entspricht.

Das Modul zur Stimmungserkennung hat viele Anwendungsfälle. Einer davon ist die Erkennung negativer Kundeneingaben, um festzustellen, dass eine Anfrage nicht automatisch beantwortet werden sollte.

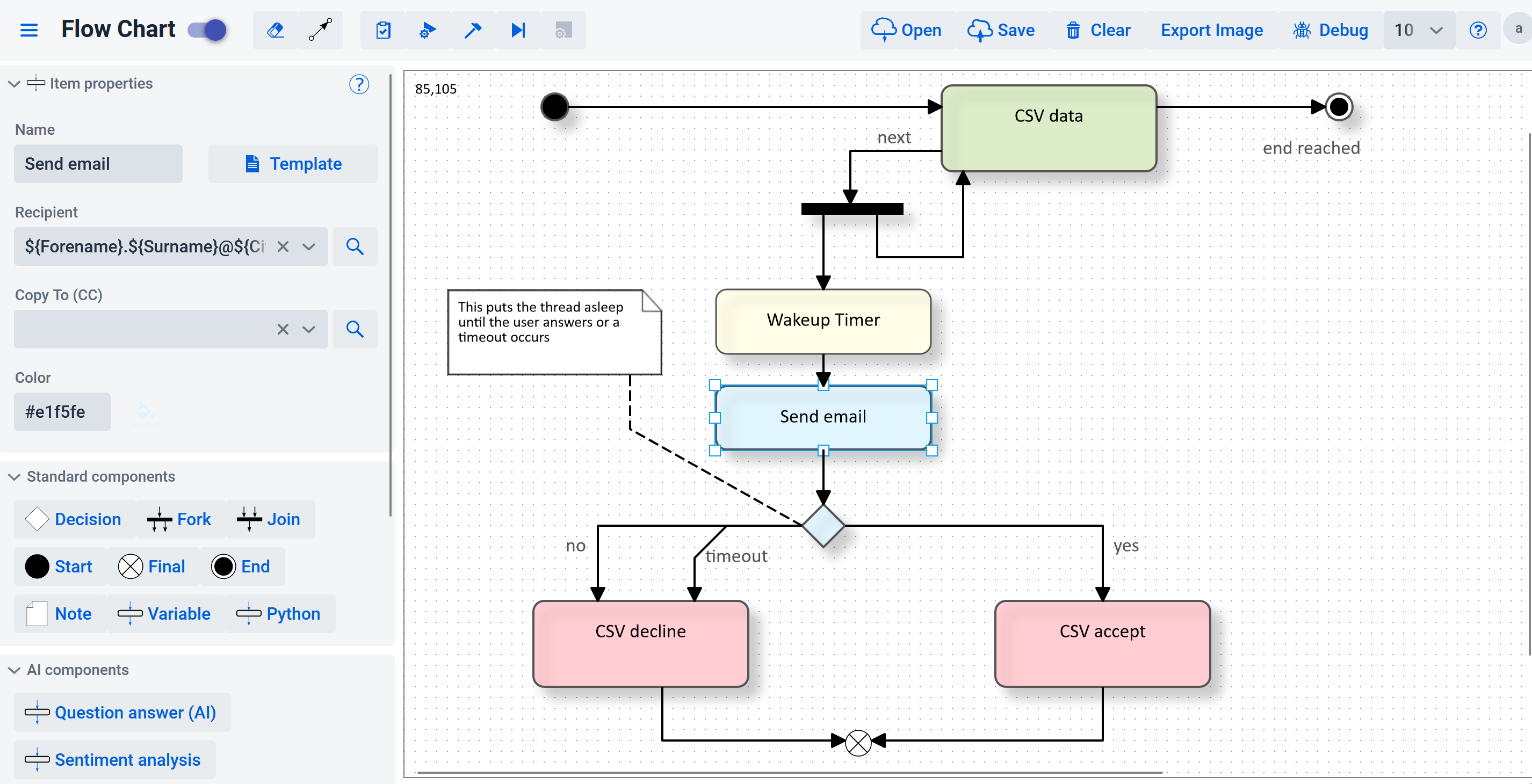

Unterstützung von asynchronen E-Mail Antwort-Clicks

Das System kann so konfiguriert werden, dass es Klicks empfängt und auf der Grundlage der vom Benutzer angeforderten Eingaben arbeitet.

In diesem Beispiel kann der Benutzer eine per E-Mail gesendete Anfrage annehmen oder ablehnen, indem er auf Links in der Nachricht klickt. Nach einer bestimmten Zeitspanne tritt ein Timeout-Ereignis auf, das die Anfrage als veraltet oder in diesem Fall auch als abgelehnt betrachten kann.

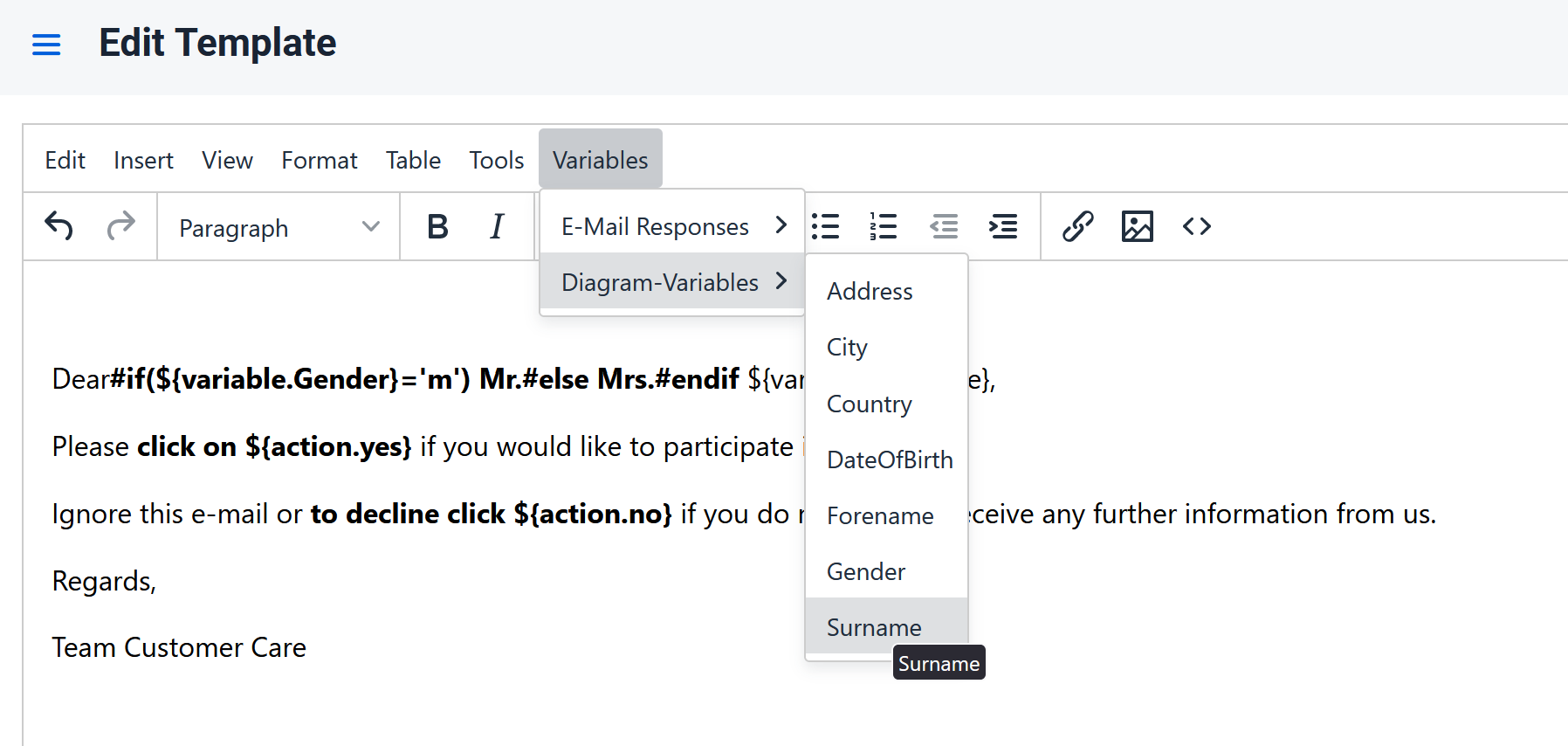

Ein Vorlageneditor mit intuitiver Oberfläche ermöglicht das Bearbeiten und Verwalten von benutzerdefinierten Texten für die Massenverarbeitung. Er unterstützt Quicklinks zum Einfügen verfügbarer Aktionen und Variablen, die aus dem Diagramm abgeleitet wurden.

Die Vorlage kann auch Makros enthalten, um zu bestimmen, welche Textausschnitte verwendet werden sollen. Das Beispiel zeigt eine geschlechtsspezifische Anrede. Alle im Workflow verarbeiteten Daten können abgerufen und in den Text eingefügt werden.

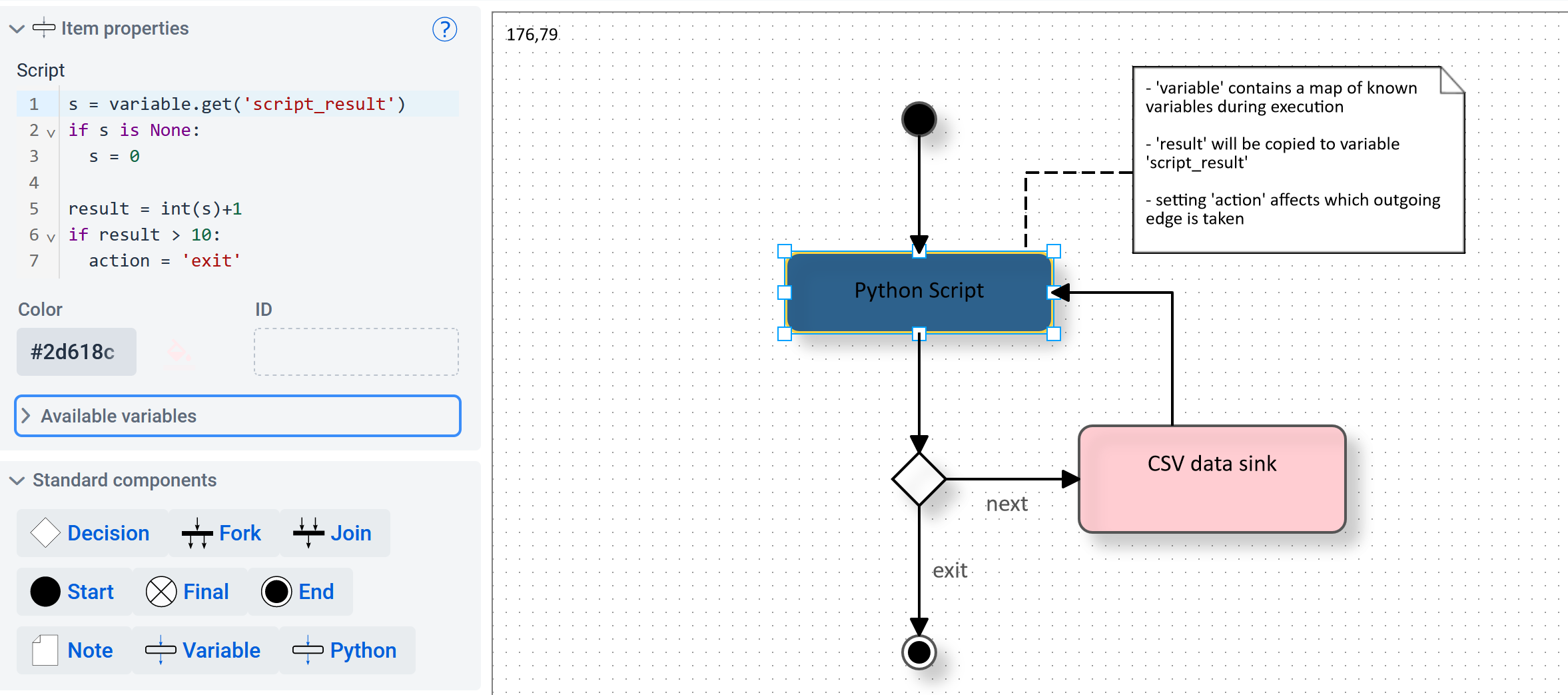

Python Skripte

Das System unterstützt Python-Skripte, die die Daten im Workflow verwenden können. Die erstellten Ausgaben können in den nachfolgenden Schritten im Diagramm verwendet werden. Auf diese Weise können Sie jeden Workflow nach Ihren Wünschen erweitern und sogar bestimmen, welchen Ausgang Sie nehmen möchten.